影响SEO排名的因素:确保爬虫可抓取页面

Google搜寻引擎透过爬虫Crawler为页面上的内容进行排名,若你的内容页面设定为「禁止访问」,或是使用javascript产出网页内容,那么爬虫将难以将其列入索引编制。

技术上来讲,工程师会利用Robots.txt这只档案来限制搜寻爬虫可索引的档案,如果误操作,可能就会爬虫无法访问网站的某些页面,也将影响网站的可见性。

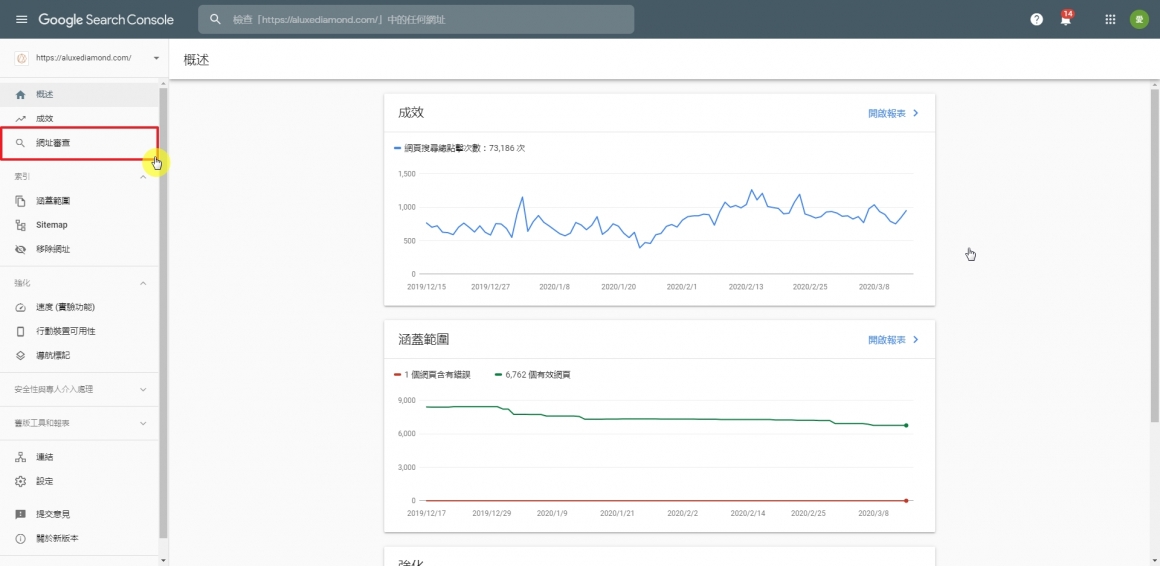

使用Google Search Console中的「检查网址」功能轻松检查页面是否完全可被搜寻引擎索引:

免责声明:1.凡本站注明“来源:XXX(非老K模板网)”的作品,均转载自其它媒体,所载的文章、图片、音频视频文件等资料的版权归版权所有人所有,如有侵权,请联系laokcms#126.com处理;2.凡本站转载内容仅代表作者本人观点,与老K模板网无关。

相关文档

- 统计数据:Google排名高的是什么样的页面?

- 怎样把Google排名优化到第0位?

- 一个关于Google排名的有趣问题

- 2017年Google SEO排名因素

- 提升网站流量与排名的实践方法

- 如何让文章有好的SEO排名?

- 影响SEO排名的因素:Google RankBrain人工智慧演...

- 影响SEO排名的因素:文章内使用关键字

- 影响SEO排名的因素:使用关键字作为连结锚点文字

- 影响SEO排名的因素:网域权威值(Domain Authorit...

- 影响SEO排名的因素:反向链接数(Backlinks)

- 影响SEO排名的因素:提供方便行动装置浏览的网站

- 影响SEO排名的因素:确保爬虫可抓取页面

- 影响SEO排名的因素:内容独特性

- 影响SEO排名的因素:内容品质

- 自然排名是什么意思?不用花钱的网站排名

- 什么是SEO?改善网站排名的工作

上一篇: 影响SEO排名的因素:内容独特性

0 条评论